Raspberry Pi 5 : extension pour exécuter Llama, Mistral ou DeepSeek localement

Raspberry Pi a lancé le AI HAT+ 2, un accessoire permettant l’exécution de modèles de langage directement sur la carte, en local, sans envoyer de données chez OpenAI ou Google. La puce Hailo-10H intégrée permet une performance de 40 TOPS en précision INT4, avec 8 Go de RAM LPDDR4X dédiée pour éviter de cannibaliser la RAM du système.

On savait que Raspberry Pi avait un intérêt pour l’intelligence artificielle, mais l’entreprise passe clairement à la vitesse supérieure avec le **AI HAT+ 2**. Ce nouvel accessoire permet d’exécuter des modèles de langage (LLM) directement sur la carte, en local, sans transférer les données vers OpenAI ou Google.

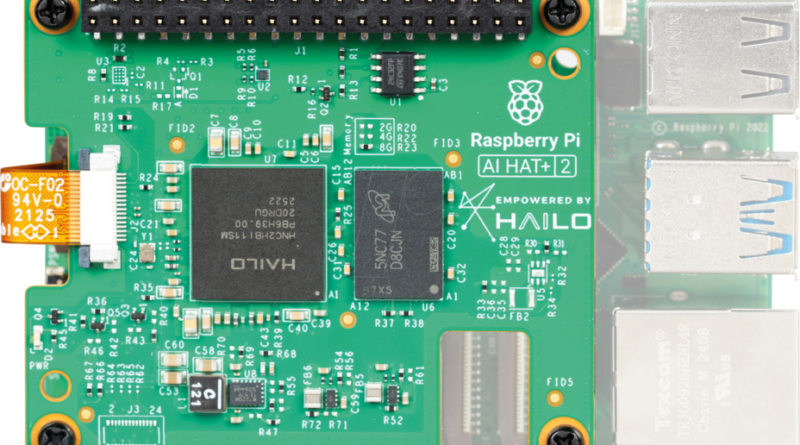

Concrètement, il s’agit d’un module qui se fixe sur votre **Raspberry Pi 5** via l’interface PCIe. Et ce n’est pas un simple accessoire. Avec un prix avoisinant les **145 euros** (ce qui peut être supérieur au coût de la carte elle-même dans certaines configurations), c’est un investissement conséquent. Mais que propose-t-il réellement pour ce tarif ? C’est ce que nous allons examiner.

Une fiche technique très correcte

Sur cette mini carte, on trouve une puce **Hailo-10H**. Si ce détail ne vous est pas familier, sachez qu’il s’agit d’un accélérateur neuronal capable de fournir **40 TOPS** (Trillions d’Opérations Par Seconde) en précision INT4. Pour donner une idée, cela correspond à la performance des NPU (Neural Processing Unit) présents dans les derniers processeurs Intel Core Ultra ou AMD Ryzen AI 300. Disposer d’une telle technologie sur un Raspberry Pi est significatif.

Cependant, la véritable « killer feature » n’est pas seulement la puissance de calcul brute, mais la mémoire. L’AI HAT+ 2 intègre **8 Go de RAM LPDDR4X dédiée**. Pourquoi est-ce essentiel ? Habituellement, quand un modèle d’IA est lancé sur un Raspberry Pi, il utilise la RAM du système, ce qui ralentit ou rend instable l’ensemble. Ici, le NPU dispose de ses propres ressources, permettant au processeur principal et à la RAM de votre Pi 5 de rester disponibles pour faire fonctionner le système d’exploitation et vos autres applications.

Raspberry Pi assure que vous pourrez faire fonctionner des modèles comme **DeepSeek-R1-Distill**, **Llama 3.2**, **Mistral** ou **Qwen**. Ces modèles comportent entre 1 et 1,5 milliard de paramètres au lancement, avec une possibilité d’augmenter cette capacité par la suite. L’architecture technique est particulièrement astucieuse, déchargeant complètement le CPU.

Le diable se cache dans les détails

Bien que les chiffres soient prometteurs, il faut tenir compte des limites physiques. La puce Hailo-10H intégrée ici est limitée à une consommation de **3 Watts**. Cela constitue un avantage en termes d’efficacité énergétique, mais restreint les performances.

Cette situation complique le positionnement du produit. Si vous possédez déjà un **Raspberry Pi 5 avec 16 Go de RAM**, vous avez déjà un système capable de gérer de grands modèles en mémoire. Bien sûr, c’est le CPU qui est alors sollicité et peut rencontrer des difficultés, mais l’extension de 8 Go sur le module peut se révéler insuffisante pour des modèles plus volumineux. Pour ceux qui exigent 10 ou 12 Go de RAM, cet accessoire pourrait être moins performant qu’un Pi 5 standard bien équipé.

De plus, l’installation physique complique l’accès facile aux GPIO si vous n’utilisez pas le réhausseur fourni, et le refroidissement peut devenir problématique si plusieurs HATs sont empilés. Cette solution semble pensée pour l’efficacité et l’inférence dédiée, plutôt que pour une puissance brute maximale.