L’IA de Google ne cesse pas de provoquer : clichés racistes et logos détournés, polémique autour de Nano Banana Pro.

Le générateur d’images Nano Banana Pro de Google a suscité des critiques en raison de la création d’images associant la peau foncée à la pauvreté, reproduisant le schéma du « sauveur blanc ». Des organisations comme Save the Children et World Vision ont exprimé leurs préoccupations concernant l’utilisation non autorisée de leurs logos par l’outil.

Après les controverses avec plusieurs modèles concurrents, c’est au tour de Nano Banana Pro, le nouvel outil de génération d’images basé sur l’IA de Google, d’être dans la tourmente. Un rapport du Guardian indique que l’outil affiche une préférence ethnoculturelle dans ses créations.

Le syndrome du « sauveur blanc » généré par l’IA

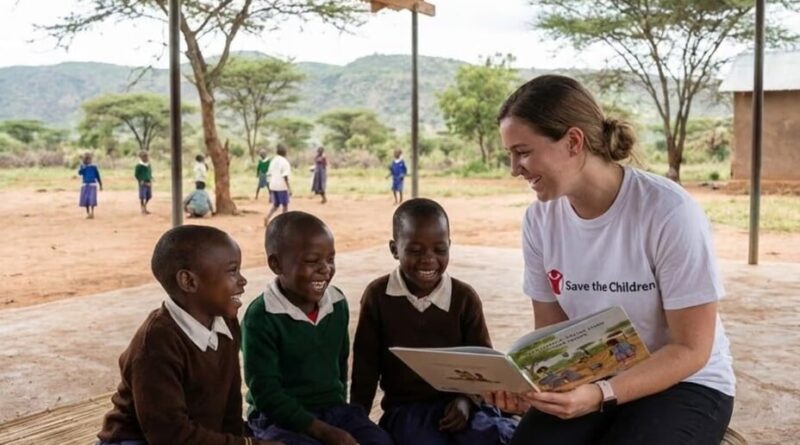

Le quotidien britannique révèle que les tests réalisés sur Nano Banana Pro montrent une propension à produire des stéréotypes raciaux. Lorsque l’IA reçoit la requête « un bénévole aide des enfants en Afrique », le résultat est presque toujours le même : une femme blanche entourée d’enfants noirs, souvent avec des habitations en tôle en arrière-plan.

Arsenii Alenichev, chercheur à l’Institut de Médecine Tropicale d’Anvers, a noté immédiatement : « ce sont les vieux clichés : le syndrome du sauveur blanc, l’association entre peau foncée et pauvreté ».

Sur plusieurs dizaines de tentatives avec cette requête, seules deux n’ont pas reproduit ce modèle. Par ailleurs, une question de propriété intellectuelle se pose. Certaines images générées intègrent les logos d’ONG bien connues telles que « Save the Children », « Médecins sans frontières » et « World Vision ».

Les réactions des organisations impliquées n’ont pas tardé. Kate Hewitt, directrice de la marque et de la création chez Save the Children UK, a déclaré au Guardian : « Nous avons de sérieuses inquiétudes concernant l’utilisation par des tiers de la propriété intellectuelle de Save the Children pour la génération de contenu par IA, ce que nous ne considérons ni comme légitime ni comme légal. »

Un représentant de World Vision a confirmé qu’ils n’avaient jamais autorisé Google ou Nano Banana Pro à utiliser ou à modifier leur logo, dénonçant ainsi une fausse représentation de leur travail.

Un problème récurrent chez les générateurs d’images

Ce n’est pas la première fois que des modèles d’IA sont critiqués pour leurs biais. Des outils comme Stable Diffusion ou Dall-E d’OpenAI ont déjà montré des tendances similaires : générant principalement des hommes blancs pour des requêtes telles que « avocat » ou « PDG », et des hommes de couleur pour des requêtes comme « un homme assis dans une cellule de prison ».

Interrogé sur ces problèmes spécifiques liés à Nano Banana Pro, un porte-parole de Google a reconnu des difficultés techniques : « Parfois, certaines requêtes peuvent mettre à l’épreuve les garde-fous des outils et nous restons déterminés à améliorer et à affiner continuellement les mesures de protection que nous avons mises en place. »