Kimi K2.5, concurrent open source « gratuit », face à Claude 4.5 et GPT-5.2

Kimi K2.5 est une startup de Pékin valorisée à 4,3 milliards de dollars, dirigée par Yang Zhilin et massivement financée par Alibaba et Tencent. Le modèle complet de Kimi K2.5 pèse 630 Go et nécessite un serveur avec 4 ou 8 GPU NVIDIA H200 pour fonctionner efficacement, engendrant un investissement dépassant les 200 000 €.

Moonshot AI vient de rappeler que la Chine ne sous-estime pas sa place sur la scène mondiale.

Le Kimi K2.5 est le produit d’une startup basée à Pékin, qui s’est rapidement imposée comme le « champion national » de l’IA. Sous la direction de Yang Zhilin, un ancien employé de Google et Meta, et soutenue financièrement par Alibaba et Tencent, l’entreprise affiche des ambitions internationales. Elle est désormais valorisée à 4,3 milliards de dollars.

Kimi K2.5 n’est pas un simple chatbot. Il a été conçu pour l’action, reposant sur une architecture complexe de type Mixture-of-Experts (MoE) qui compte environ un trillion de paramètres. Sa structure permet d’être à la fois extrêmement puissant et relativement optimisé lors de son utilisation.

Le modèle a été alimenté par une quantité impressionnante de données : environ 15 000 milliards de tokens de texte et de vision. On constate un entraînement « multimodal natif », indiquant que Kimi K2.5 ne se limite pas à la description d’une image, mais la comprend comme un texte.

L’Agent Swarm

La véritable innovation technique réside dans ce que Moonshot nomme l’Agent Swarm. Plutôt que d’assigner une tâche à une seule IA, le modèle peut constituer et coordonner automatiquement jusqu’à 100 sous-agents. Chaque agent se concentre sur une micro-tâche, ce qui permet jusqu’à 1 500 appels d’outils ou d’API simultanément.

Par exemple, si vous lui demandez de construire un modèle financier complexe à partir de dix PDF, il n’analyse pas les documents un par un. Il déploie ses agents pour extraire les données, les croiser et générer les tableaux Excel en parallèle.

| Benchmark (Agentic Search) | Kimi K2.5 (Swarm) | GPT-5.2 (xhigh) | Claude 4.5 Opus |

| BrowseComp | 78.4 | 65.8 | 57.8 |

| WideSearch (f1) | 79.0 | — | 76.2 |

D’après les premiers retours, cette approche serait environ 4,5 fois plus rapide qu’un agent traditionnel. Il s’agit de l’IA « agentique » à son meilleur : elle ne se contente pas de fournir la recette, elle cuisine réellement.

Lors d’évaluations de haut niveau telles que AIME 2025 ou GPQA-Diamond, Kimi K2.5 (en mode Thinking) se rapproche de GPT-5.2. Toutefois, c’est dans le domaine de la vision et de la vidéo qu’il prend clairement les devants.

Cette puissance se manifeste également à travers des capacités de « Visual Coding » qui suscitent admiration selon les premiers retours. En fournissant une capture d’écran d’un site web, il produit le code HTML/CSS prêt à l’emploi. On s’approche des fonctionnalités de Claude 4.5 Opus, avec une agilité technique qui pourrait séduire les développeurs désillusionnés par les limitations des modèles propriétaires.

La stratégie de Moonshot AI est intéressante. En proposant Kimi K2.5 sous une licence inspirée du MIT (quasi open source), la startup vise à construire un écosystème global permettant de réduire la dépendance vis-à-vis des modèles américains. Cela représente une manière d’affronter directement OpenAI, Anthropic, et Google.

Cette décision est à la fois politique et technique. Moonshot fournit des API compatibles et des outils de fine-tuning pour adapter ce modèle puissant aux besoins spécifiques de chacun.

Comment l’utiliser ?

Bien que Moonshot AI publie Kimi K2.5 en open source, la réalité matérielle est plus complexe. Il ne sera pas facile d’installer le modèle, même avec sa disponibilité en open source.

Le modèle complet nécessite 630 Go d’espace. Pour une utilisation optimale, un simple PC portable, un Mac mini, ou un PC de gaming ne suffisent pas. Vous aurez besoin d’outils spécifiques comme llama.cpp (dans des versions optimisées par la communauté) ou Unsloth pour tirer parti des versions compressées.

Pour aller plus loin

Comment installer un modèle LLM type ChatGPT sur PC ou Mac en local ? Voici le guide ultime pour tous

Voici ce qu’il vous faut concrètement :

- Configuration « pas cher » : une RTX 4090 (24 Go de VRAM) et 128 Go de RAM. Vous devrez utiliser une version ultra-compressée (quantisation 1.8-bit). La vitesse ? Environ 0,4 token par seconde. Cela représente une option lente et coûteuse.

- Configuration recommandée : un Mac Studio M3 Ultra avec 512 Go de RAM unifiée. C’est le minimum pour obtenir un débit situé entre 5 et 10 tokens par seconde. Coût total de cette configuration : environ 14 000 €.

- Mode pro : un serveur doté de 4 ou 8 GPU NVIDIA H200 (d’une capacité de 141 Go de VRAM chacun). Là, l’investissement dépasse les 200 000 €.

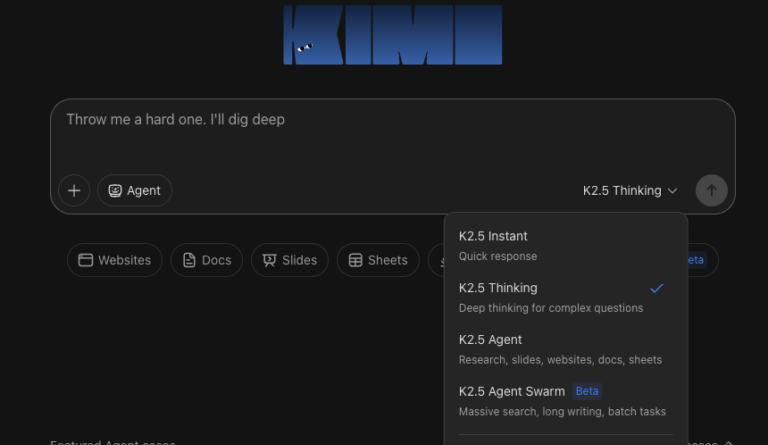

Même si Kimi K2.5 est proposé comme un modèle open source, l’écosystème qui l’entoure rappelle beaucoup les solutions proposées par des acteurs fermés comme OpenAI, Google ou Anthropic : Moonshot AI fournit non seulement le LLM, mais aussi une interface de type “ChatGPT” accessible gratuitement pour tester le modèle en ligne, ainsi qu’un environnement de type CLI/éditeur orienté code, comparable à Claude Code ou aux anciens outils comme Codex (incluant exécution, gestion de fichiers, etc.), ce qui transforme la plateforme en un ensemble complet plutôt qu’un simple dépôt de poids de modèle.